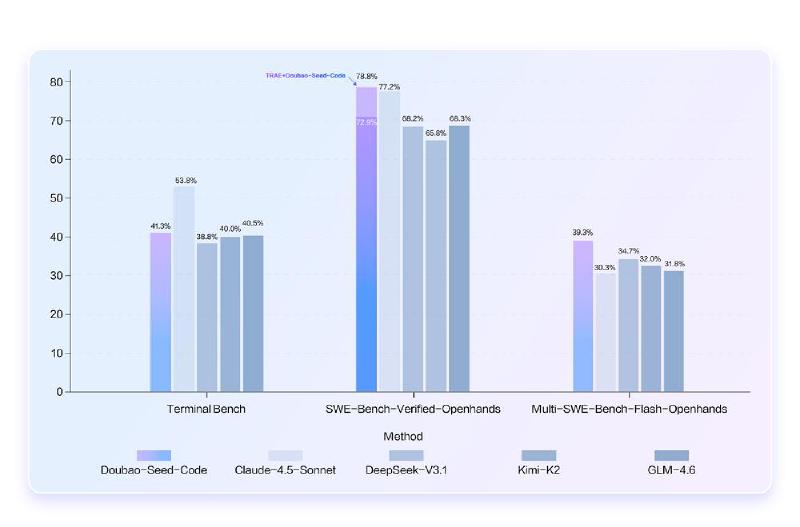

今天,我又测试了一下 doubao-seed-code,一个登顶的 coding llm model。

我们可以看到强度甚至超过了 swe-agent + claude 4.5 sonnet。

评测目的

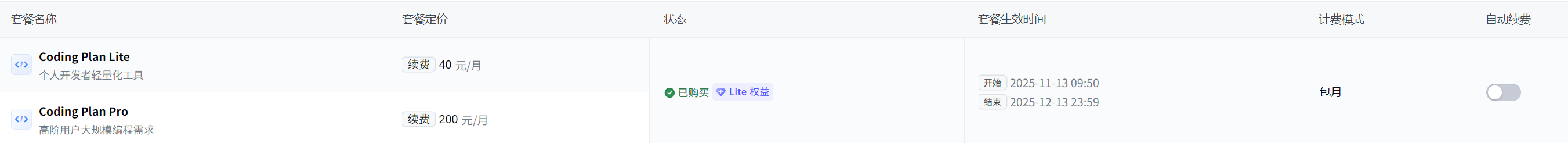

- 看能否替换 claude max;claude max 价格是 $100;人民币大概 700 块左右

配置问题

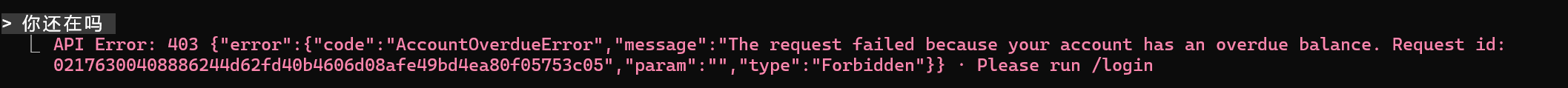

但是我在配置过程中遇到了不少问题。一个比较大的问题是没有完全按照官网配置,按照其他博主的博客做的配置。导致实际上没有使用 coding plan,花了1块钱。

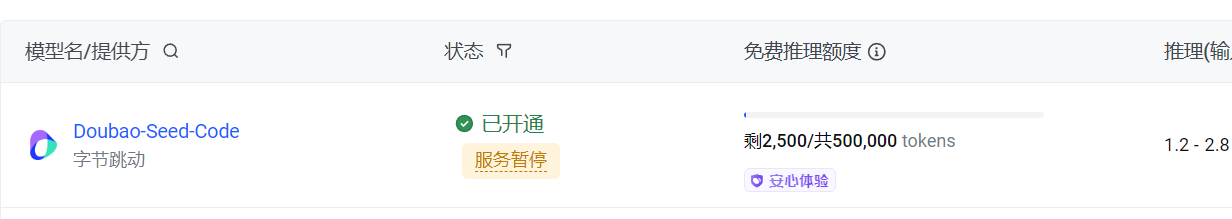

具体的问题是,在使用 api 的时候,如果订阅了 coding plan,不能用兼容的 api,应该用 coding api。

| |

也就是下方的 /coding endpoint。

另外,这种配置方法,是我的一种配置思路,在 动态切换 Provider 的 Claude Code 提到了。

实际使用感受

从 swe-benchmark 出发的基本性能上看,我认为能力应该不会太弱,大致上至少追到 minimax-m2 的水平。

问题1:速度比较慢。

我配置 /statusline 大概花费了接近半个小时的时间。就是 claude "/statusline"操作。最终修改.claude配置的时候,没有按照我指定的配置去修改。

| |

也就是说这个配置意义不是很大。实际使用下来可能会出现挺多新问题。

解决思路

私以为蒸馏一下模型应该不是难事。可能是蒸馏之后担心模型能力下降?大概 300B 的某模型就是例子。

问题2:规划性问题

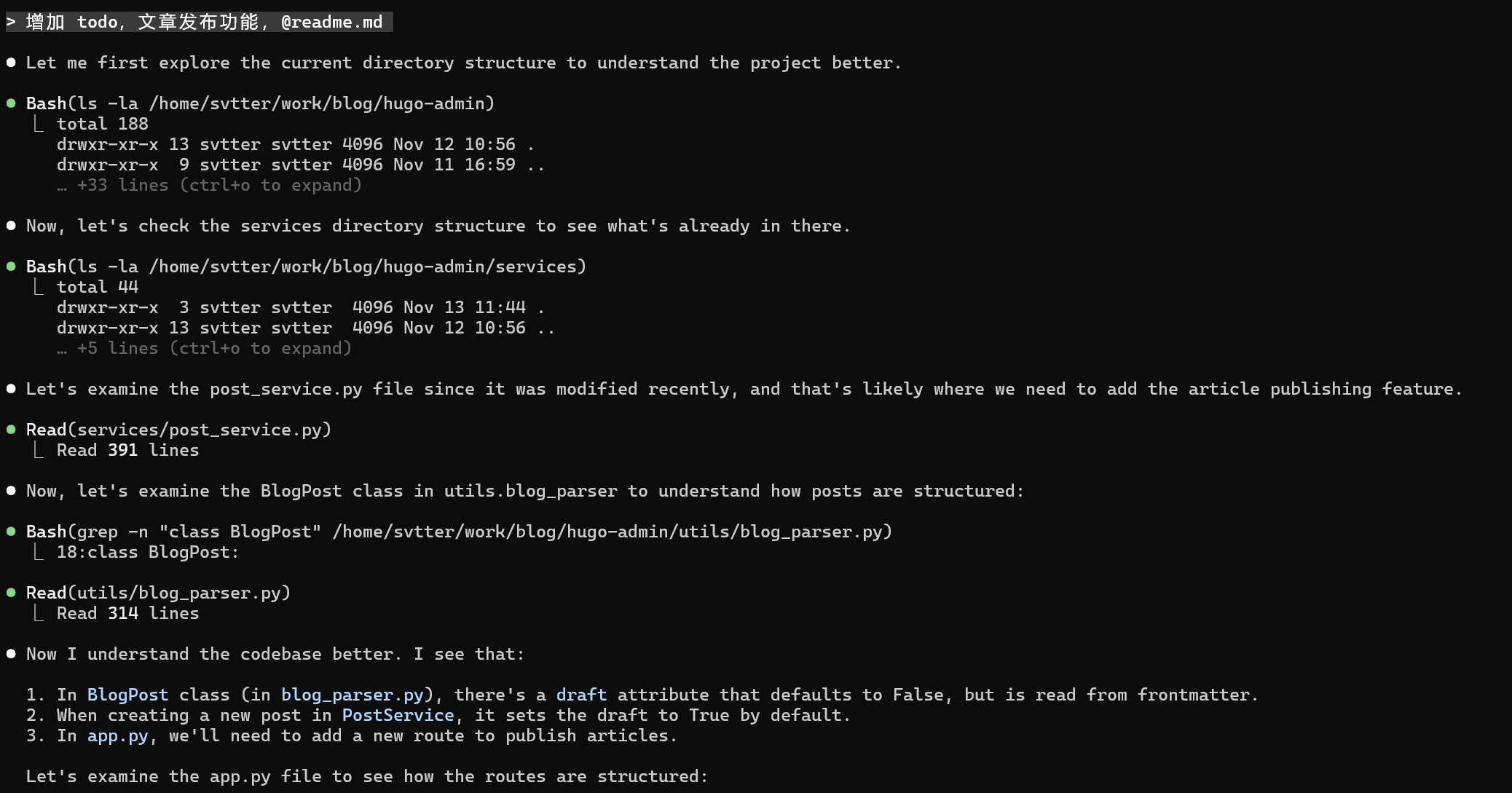

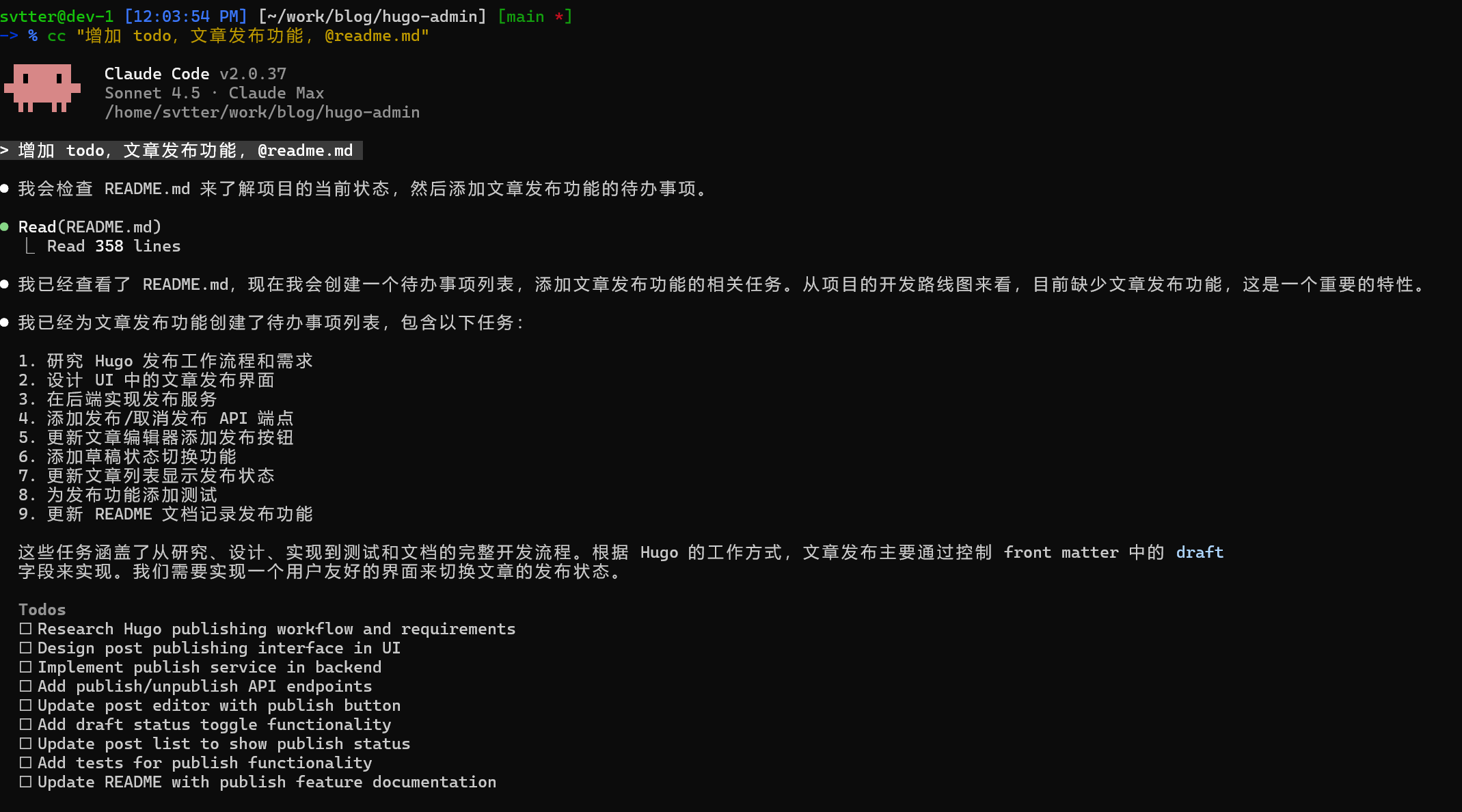

我的 prompt:增加 todo,文章发布功能,@readme.md.

修改的项目是:

豆包的做法:

直接去改了文件,然后请求我的允许。

claude sonnet 的做法:

孰优孰劣,各位自有评判。

结论

总体来说不如 cc + claude 4.5 sonnet。但是,使用 claude code 直接测试 doubao 的强度,对 doubao 是不公平的。terminal bench 实际上就是不如 sonnet。如果想要看看到底多强,还是应该安装 trae 来测试。